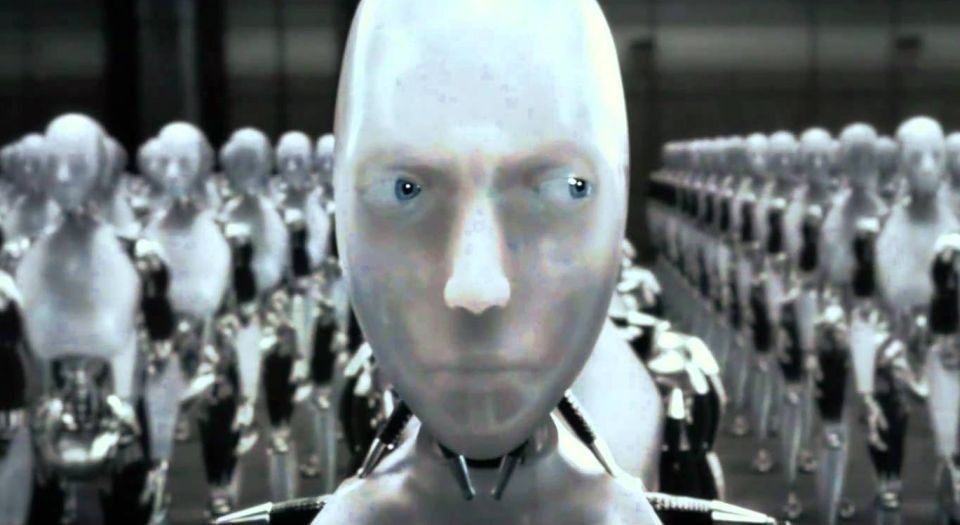

En un nuevo reporte llamado “El malicioso uso de la inteligencia artificial”, los autores advierten que si los avances en esta área continúan al paso acelerado que llevan actualmente, tarde o temprano se convertirán en un problema para otros sistemas físicos y digitales.

Jack Clarke, director de OpenAI, grupo de investigación sobre la tecnología de inteligencia artificial con base en San Francisco, dijo: “Lo que impresiona a muchos de nosotros es la manera en que ha evolucionado todo en los últimos cinco años”.

Añadió: “Si eso continúa se ven oportunidades de crear cosas realmente peligrosas”.

[Lee también: Apagan por precaución inteligencia artificial que se salió de control y creó su propio lenguaje]

También advierte que los drones y los autos sin conductor pueden ser hackeados y usados como armas letales.

Los sistemas políticos también podrían ser hackeados usando herramientas online de publicidad y así manipular votos. Esto lo lograrán a través de una “capacidad de analizar el comportamiento humano, humor y creencias registrado en la base de datos del usuario”.

[Podría interesarte: Esta cámara web "cobró vida" y aterrorizó a su dueña]

El grupo de investigadores que incluye a Elon Musk, Peter Thiel y un grupo de investigadores de la Universidad de Oxford también ha llamado a abrir un debate entre el público abierto acerca del CRISPR, un complejo sistema para la edición genética que ya se ha usado en distintas especies.

El célebre físico Stephen Hawking también ha advertido acerca de la inteligencia artificial: “Podría ser el evento más catastrófico para la civilización” dijo el científico. En una nota más positiva, aclaró que los humanos deberían aprender a controlarla, ya que podría ayudar a vencer enfermedades y cambiar todos los aspectos de la sociedad.

¿Tú qué crees? ¿Realmente estamos cada vez más cerca del control total de las máquinas? ¿O estarán exagerando? ¿Cuáles pueden ser los beneficios del avance de la inteligencia artificial? Dinos lo que piensas.

Global

Global

México

México

España

España

Argentina

Argentina

Colombia

Colombia

EEUU

EEUU

Chile

Chile

Perú

Perú

Costa Rica

Costa Rica

Uruguay

Uruguay